Au cœur de l’âge d’or de la micro-informatique, une limitation technique a marqué les esprits : la fameuse barrière des 640K de RAM sur les PC. Si aujourd’hui, ce chiffre peut sembler dérisoire face aux gigaoctets de mémoire que l’on retrouve dans nos ordinateurs, il était à l’époque un sujet brûlant. Mais d’où vient cette limitation et pourquoi a-t-elle été mise en place ? Cet article retrace cette partie fascinante de l’histoire informatique.

Le contexte historique

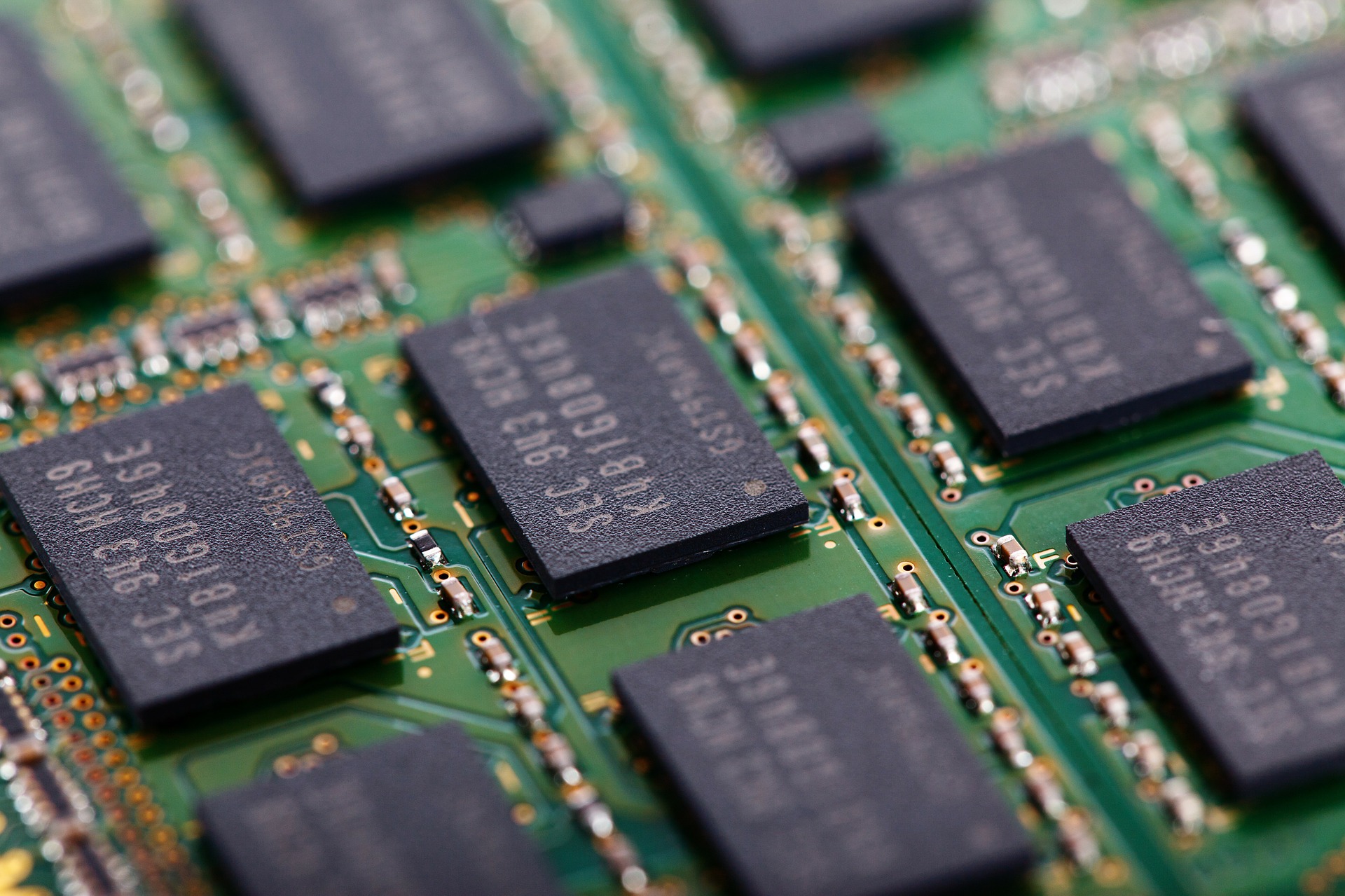

Lorsque IBM lance son premier PC en 1981, le micro-ordinateur est équipé du système d’exploitation MS-DOS développé par Microsoft. À cette époque, la mémoire vive (RAM) est encore un composant coûteux et les ordinateurs personnels sont généralement livrés avec bien moins d’un mégaoctet de RAM.

L’architecture des premiers PC

La conception originale des PC basée sur le processeur Intel 8088 offrait une capacité d’adressage maximal de 1 mégaoctet (Mo) de mémoire. Cependant, cette mémoire n’était pas exclusivement réservée à la RAM. Elle devait également accueillir d’autres éléments, tels que la mémoire vidéo, les cartes d’extension et le BIOS.

L’allocation des 1 Mo

La mémoire de 1 Mo était divisée comme suit :

- Les 640 premiers Ko étaient alloués à la RAM conventionnelle, celle utilisée par les applications et le système d’exploitation.

- Les 384 Ko restants, appelés « mémoire haute », étaient réservés aux cartes d’extension, à la mémoire vidéo et au BIOS.

Cette répartition est devenue le standard de facto pour les PC sous MS-DOS.

Une décision logique ?

Avec le recul, cette limitation peut sembler arbitraire, voire absurde. Cependant, en 1981, très peu de personnes auraient pu anticiper que les ordinateurs nécessiteraient plus de 640K de RAM pour les applications courantes. La plupart des logiciels de l’époque, y compris le système d’exploitation lui-même, étaient extrêmement compacts en comparaison avec les normes actuelles.

La controverse des « 640K devraient suffire »

Un mythe persistant veut que Bill Gates ait déclaré : « 640K devraient suffire à n’importe qui ». Bien que cette citation soit largement rapportée, elle est probablement apocryphe. Gates lui-même a nié avoir jamais tenu ces propos. Quoi qu’il en soit, la phrase capture bien l’esprit d’une époque où les ressources informatiques étaient utilisées avec une extrême parcimonie.

Les conséquences de la barrière des 640K

Au fur et à mesure que les logiciels devenaient plus complexes et que la demande en mémoire augmentait, la limitation des 640K est devenue un véritable casse-tête pour les développeurs. Ils ont dû inventer des solutions de contournement, comme le chargement de portions de logiciels en mémoire haute ou l’utilisation de techniques de « swap » pour jongler avec la mémoire disponible.

La percée : l’extendeur de mémoire

La solution à la limitation des 640K est finalement venue sous la forme d’extendeurs de mémoire, qui permettaient aux logiciels d’accéder à plus de mémoire en contournant les restrictions du mode réel du processeur. Ces extendeurs, associés à des systèmes d’exploitation plus avancés comme Microsoft Windows, ont finalement rendu la barrière des 640K obsolète.

Leçons tirées

La limitation des 640K de RAM est un rappel puissant de la rapidité avec laquelle la technologie évolue. Ce qui semblait être une énorme quantité de mémoire à l’époque est maintenant dérisoire, même pour les gadgets les plus simples.

Conclusion

L’histoire de la barrière des 640K nous enseigne que les décisions technologiques, même si elles sont logiques à un moment donné, peuvent rapidement devenir des entraves. Alors que nous contemplons l’avenir de l’informatique, il est bon de se souvenir des leçons du passé et d’adopter une approche flexible et adaptative face à l’évolution rapide de la technologie.